Cet ouvrage est le pendant anglais du travail de thèse de son autrice, soutenu à l’Hochschule für Gestaltung Offenbach am Main (Allemagne) et comme son nom le suggère, il s’intéresse au phénomène des emojis, et comment ils deviennent des outils pour la communication visuelle.

Un livre qui ne passe pas inaperçu

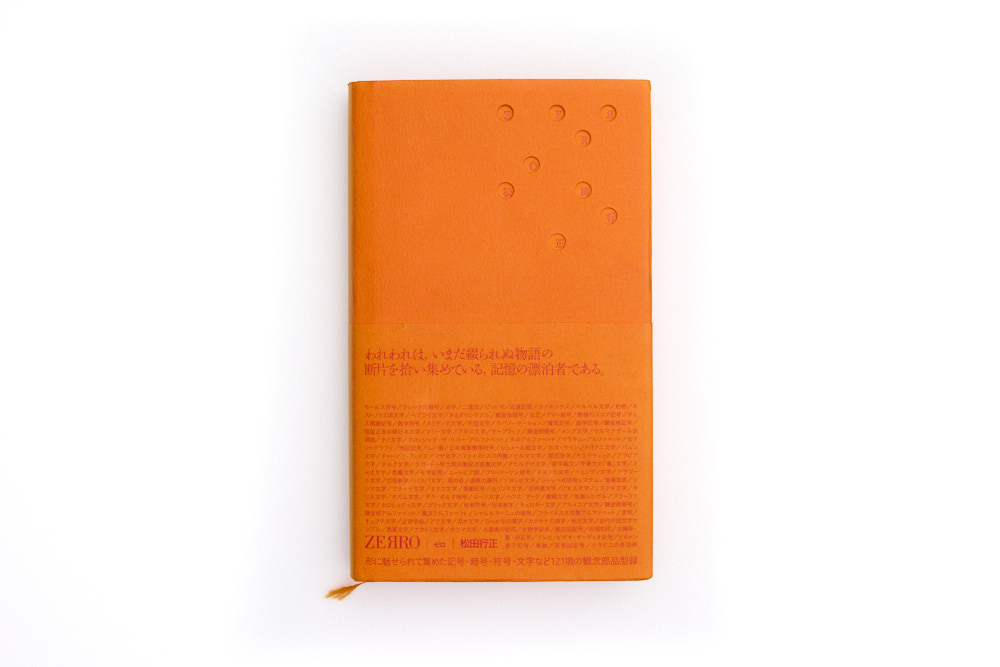

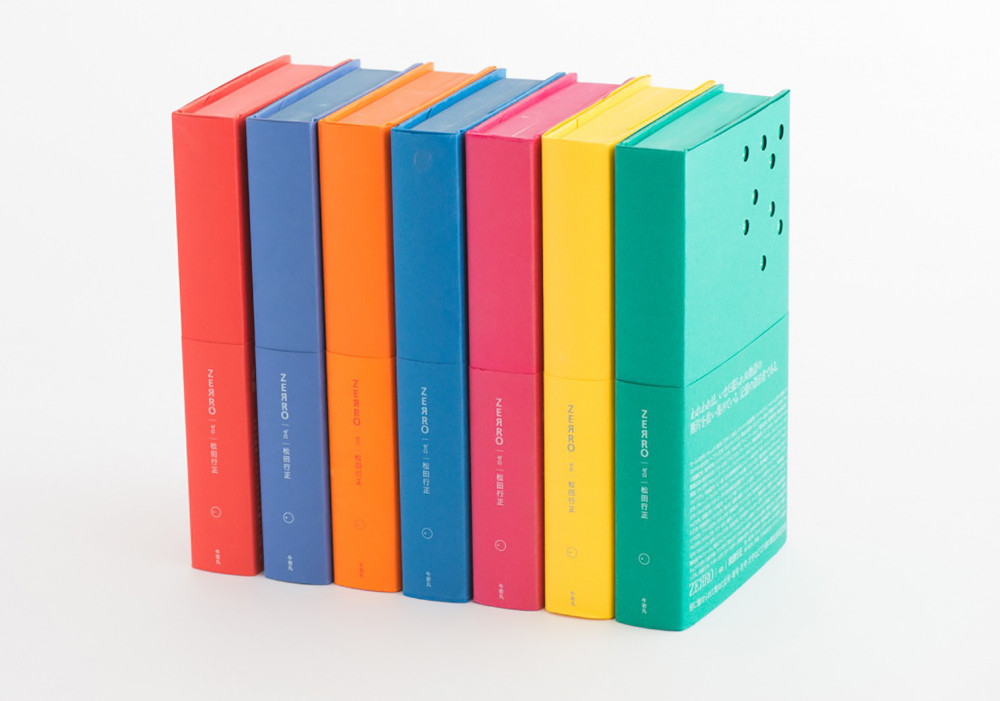

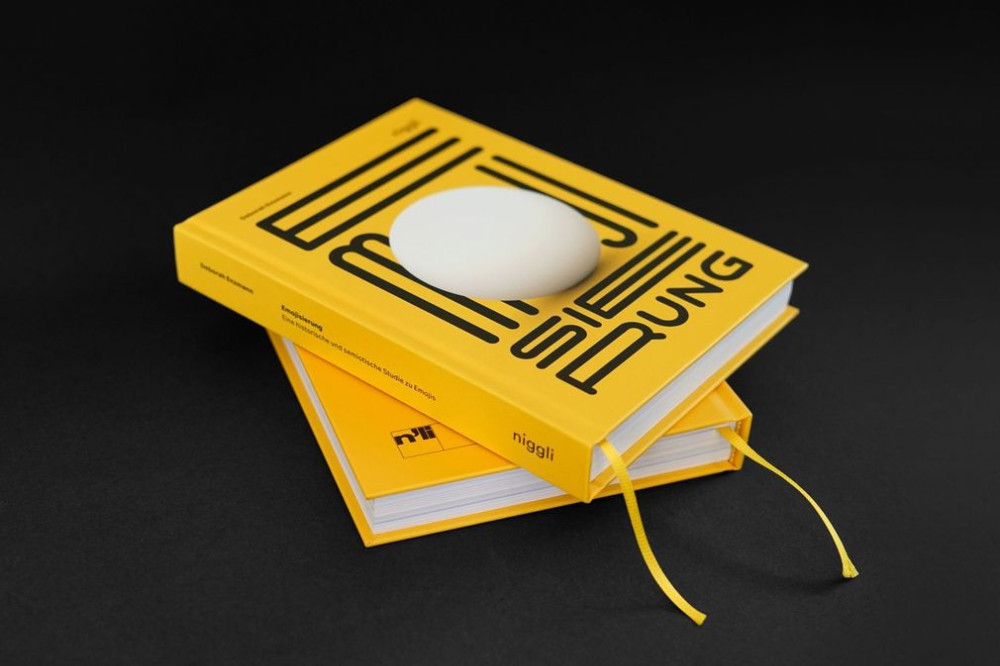

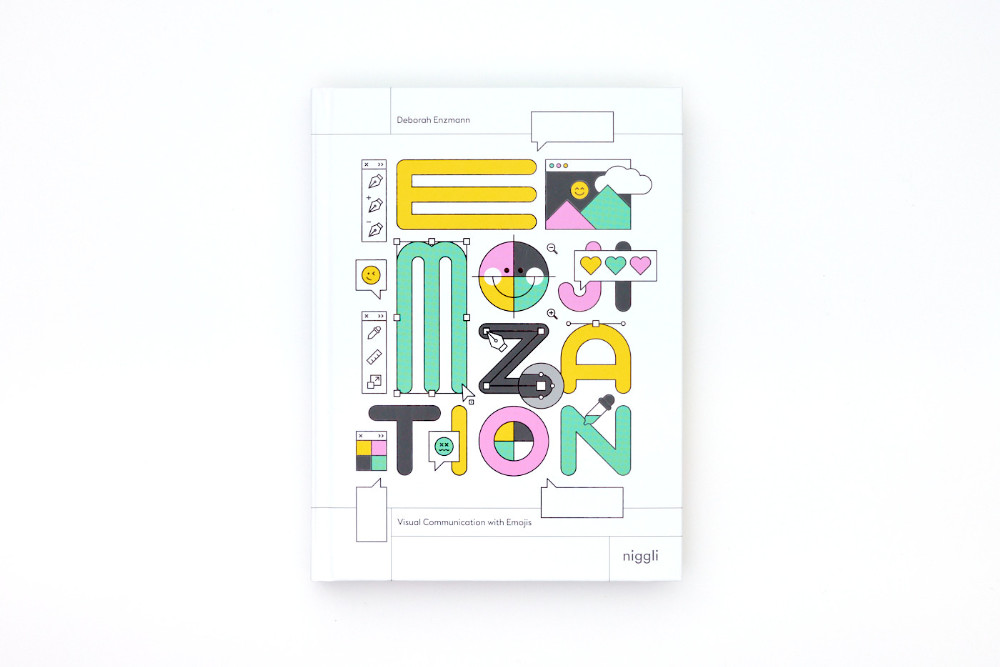

Si le livre orignal, Emojisierung, publié chez le même éditeur (en langue allemande), était relativement sobre par son aspect, cet ouvrage (en langue anglaise donc) est sur une ligne graphique bien plus expressive. Cela commence par sa couverture, qui certes est sur fond blanc, mais imprimé d’éléments vectoriels en quatre couleurs de fond, avec un verni sélectif sur l’ensemble des contours noirs. Si cela suffit déjà à attirer l’œil, les tranches du livre finissent d’enfoncer le clou puisqu’elles sont entièrement imprimées en utilisant le design général et les couleurs de la couverture pour former une phrase : « form becomes content », tout un programme donc.

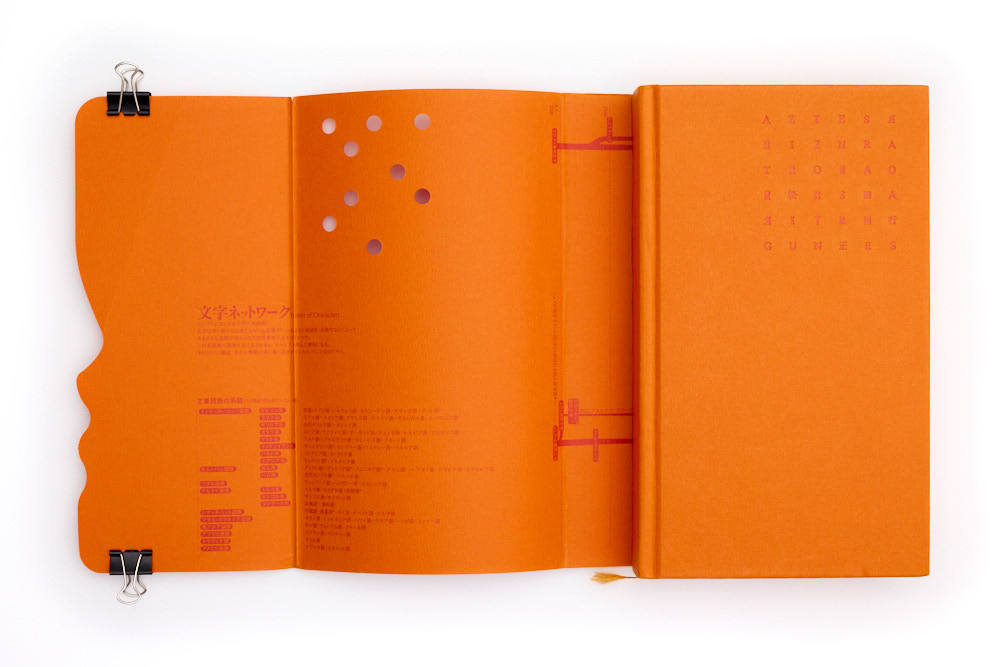

À l’ouverture on remarque ensuite une planche de stickers, présentant un certain nombre d’emojis dans un design qui semble être la marque de son autrice – qui est également designer graphique – et que l’on retrouve également sur ses réseaux sociaux.

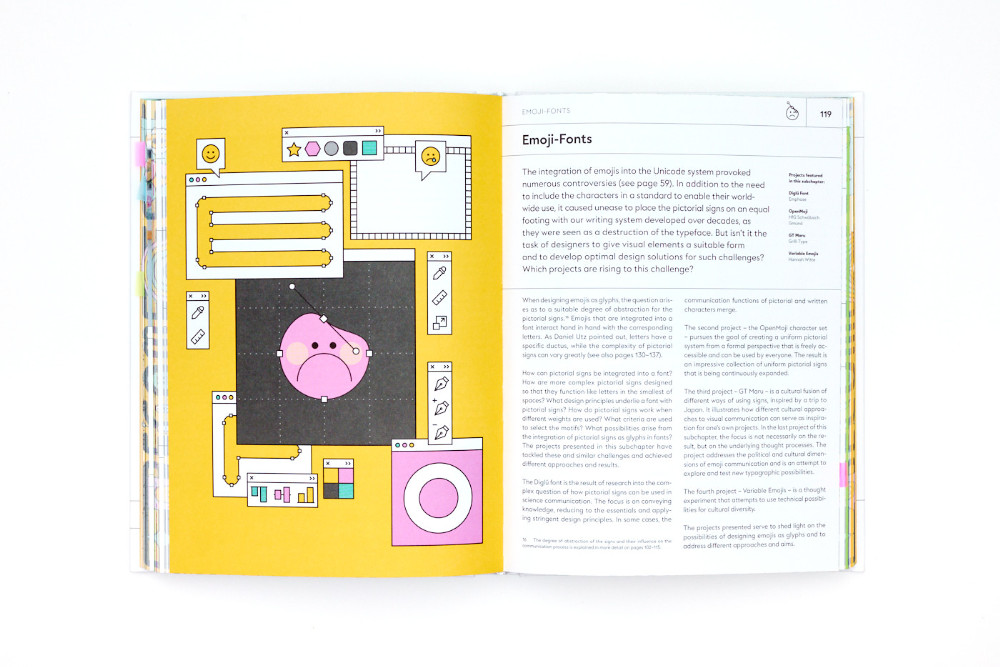

À l’intérieur, l’ouvrage suit la ligne directrice présentée sur la couverture, avec un usage intensif des quatre couleurs de base appliquées en aplats et une découpe de la grille de composition par des rectangles pour séparer les titres, les textes, les numéros de page, les images et leurs légendes. Si la chose peut paraitre un peu rigide, l’ensemble tient toutefois assez bien la route, la segmentation variant régulièrement, et étant amendée en certaines occasions par des éléments visuels qui viennent « recouvrir » cette grille. Des têtes de chapitre entièrement illustrées viennent enfin compléter l’ensemble du système graphique du livre.

À l’équilibre entre vulgarisation et science

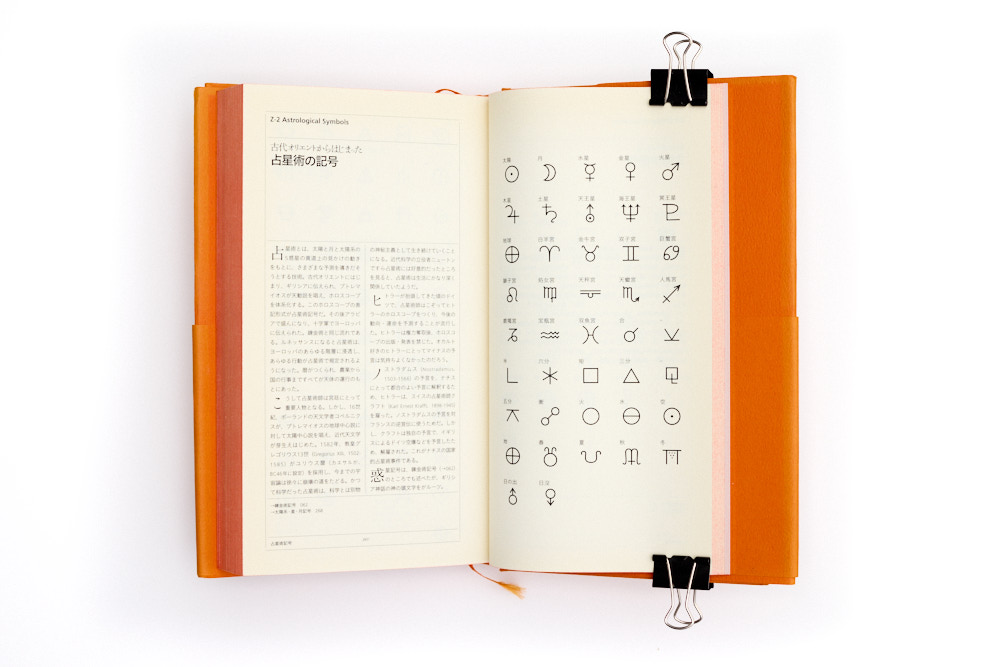

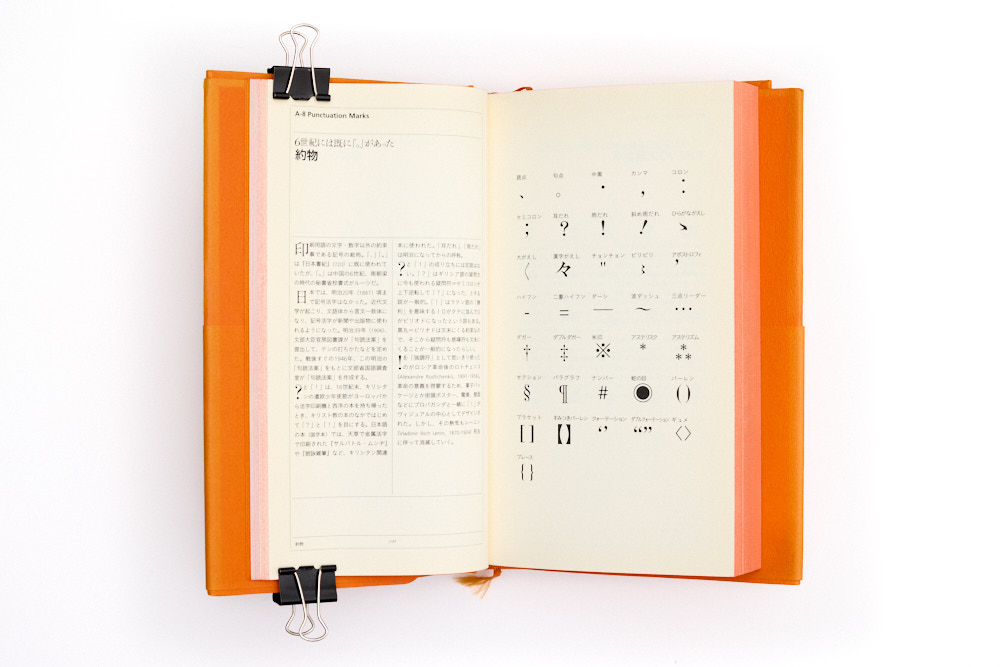

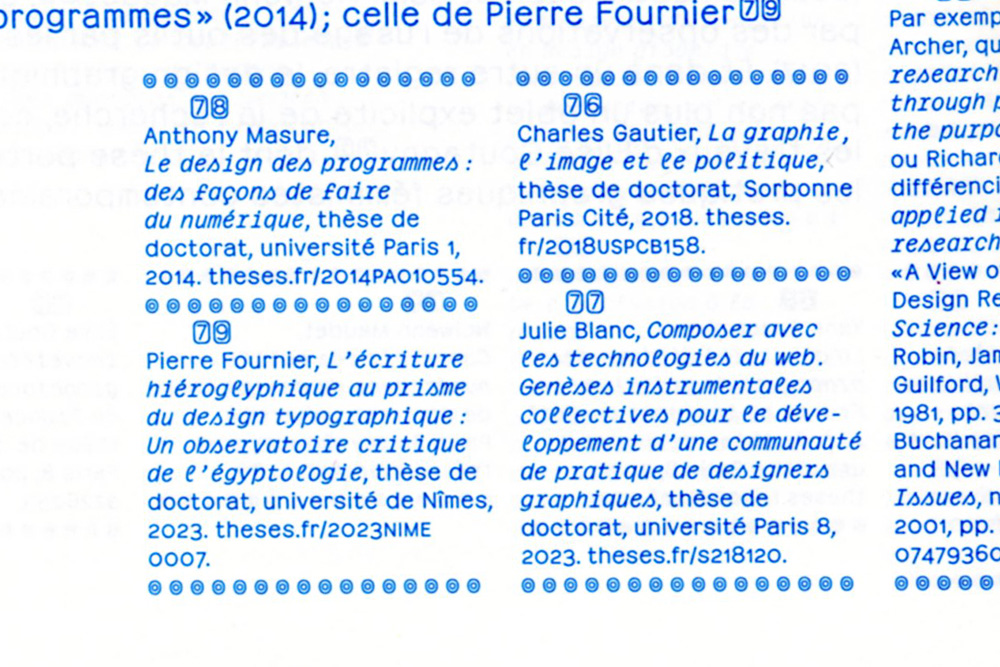

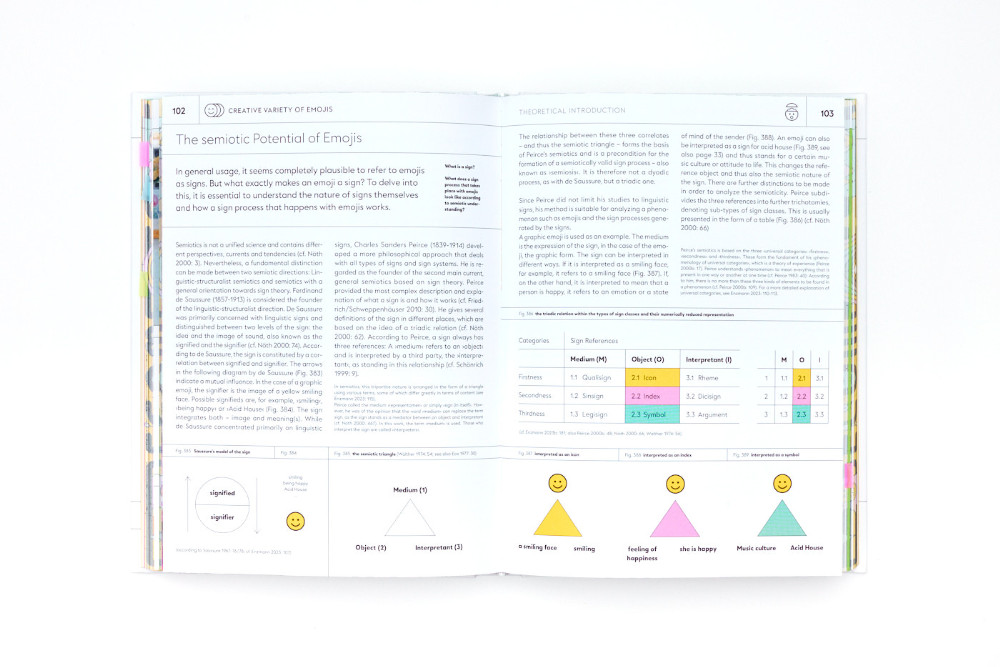

L’ouvrage étant tiré d’une thèse mais vraisemblablement ciblé vers le grand public, on aurait pu s’attendre à une certaine forme de simplification de l’écriture et de son style mais ce n’est pourtant pas tout à fait le cas. En effet les notes de bas de page, les renvois vers les figures et vers la bibliographie en fin d’ouvrage sont assez nombreux, ce qui dénote assez avec l’aspect graphique de l’ouvrage, quant à lui très « pop ». Difficile de savoir ce qu’il en était de l’écrit de la thèse soutenue ou du livre original, mais comme son aspect graphique, le texte est très segmenté en chapitres et sous-chapitres, avec à chaque fois un rappel de ce qui y sera abordé. Si ces coupes stoppent régulièrement la lecture, elles permettent néanmoins de bien suivre la logique de construction du livre. La première partie revient assez logiquement sur l’histoire des emojis, leurs prémices et leurs évolutions, depuis des dessins dans des manuscrits en passant par un smiley dans France-Soir jusqu’à l’informatique et l’explosion que l’on connait actuellement. La seconde partie revient quant à elle sur le cœur du questionnement d’Enzmann, et notamment sur des enjeux sémiologiques liés aux emojis : stylisation, symbolique, rapport aux langues, aux écritures, etc., en se basant sur la triade icônes – symboles – indices de Peirce. La troisième et dernière partie est elle celle qui fait écho au sous-titre du livre : Visual Communication with Emojis, et montre via des cas d’étude les possibilités d’usage des emojis pour la communication graphique.

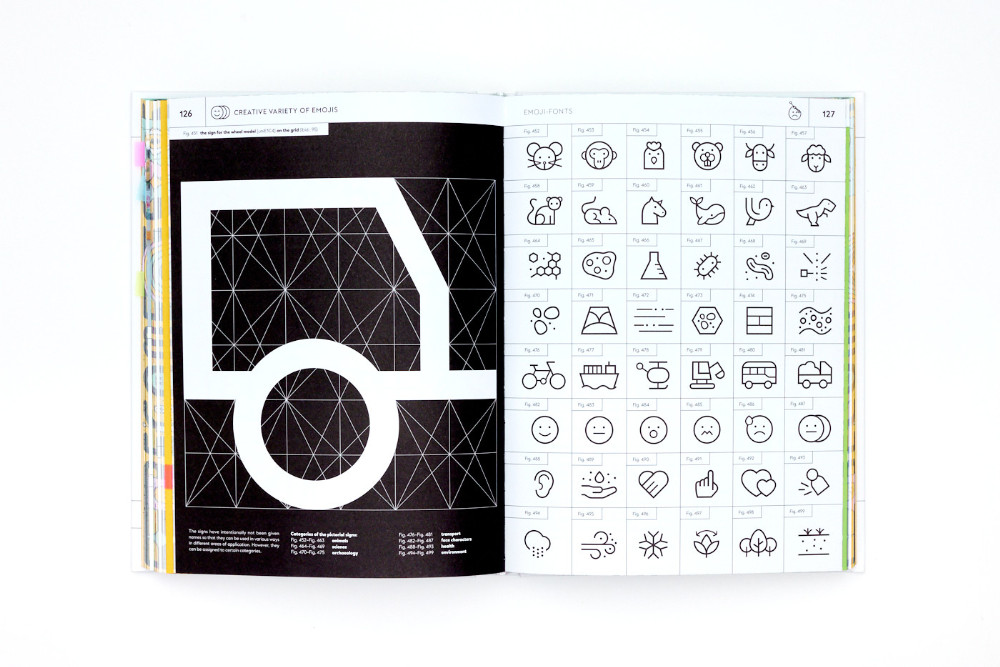

Très richement illustré, le livre propose régulièrement des pages entières d’emojis venant appuyer le texte, ce qui en fait en soit un livre de références graphiques viable pour les emojis mais également, dans une vue plus large, pour l’illustration en général, Enzmann défendant une vision élargie de la définition même d’emoji.

Quelques détails impromptus, une production trop rapide ?

Ce qui frappe en lisant le livre, c’est la présence relativement récurrente d’erreurs de microtypographie, notamment sur des doubles espaces, mais également le choix assez étonnant d’utiliser les guillemets chevrons dans une disposition allemande »ein Apfel«, alors que le texte est en anglais et que l’on attendrait donc plutôt “an apple”. À relever également un certain nombre de fautes d’orthographe. N’étant pas bilingue anglophone, il est probable que les fautes repérées ne soient que la partie immergée de l’iceberg, mais quoi qu’il en soit, si ces fautes en sont bien, c’est assez gênant. Dans un cas également, une phrase a été doublée dans le texte. Enfin, si le livre est bien sorti en 2024, le colophon indique un copyright en 2025. À croire que le livre a été produit un peu dans la hâte et n’a pas bénéficié d’une relecture suffisamment attentive.

Point possible de compréhension de ces grains de sable, une mention dans le colophon : « AI-based tools were used to translate and enhance the wording of the text » [des outils basés sur l’IA ont été utilisés pour traduire et améliorer la formulation du texte]. En l’état, cette utilisation d’IA ne devrait pas se substituer à une relecture humaine finale qui aurait vraisemblablement pu détecter et corriger tous ces soucis.

Pour celles et ceux qui veulent s’intéresser aux emojis, cet ouvrage est une bonne porte d’entrée avec beaucoup d’illustrations, de références, une histoire de l’emoji claire et, semble-t-il, assez exhaustive avec un angle de vue très orientée vers le design graphique, là où d’autres ouvrages comme The Emoji Code (Vyvyan Evans, 2017) et The Semiotics of Emojis (Marcel Danesi, 2017) étaient centrés avant tout sur leurs aspects sémiologiques. À lire donc.

Suite à un échange de messages, Deborah Enzmann a apportée quelques précisions sur des éléments du texte : tout d’abord, le choix des chevrons à la mode allemande est délibéré, pour des raisons esthétiques ; secondement, l’IA a été utilisée pour la traduction, avec un travail de relecture humaine ensuite.

- Emojization – Visual Communication with Emojis, Deborah Enzmann, Niggli, 2024

- Emojisierung – Eine historische und semiotische Studie zu Emojis, Niggli, 2023

- @deborahenzmann, Instagram (source)